Google は Android 版 Gemini アプリにおいて、ユーザーが手動でボタンをタップしなくても、画面上のコンテンツを自動的に認識・分析する新機能の展開を開始しました。

これまで Gemini に画面上の内容について質問する場合、ユーザーはオーバーレイメニューにある「画面について質問する」ボタンをタップするか、スクリーンショットを添付する必要がありました。しかし、今回のアップデートでそのひと手間がなくなります。

プロンプトの文脈から「画面を見るべきか」を判断

この新機能は「画面のコンテキスト (Screen Context)」と呼ばれており、ユーザーが入力したテキストプロンプト(質問内容)を分析し、画面上の情報が必要だとシステムが判断した場合に、自動的に現在の画面のスクリーンショットを取得して解析に回すというものです。

例えば、Gmail で「添付ファイル」という言葉を書きながらファイルを添付し忘れると警告が出る機能のように、Gemini もユーザーの意図を汲み取ろうと進化しています。

もしユーザーが動画を見ている最中に「この動画のロケ地はどこ?」と Gemini に尋ねれば、わざわざ「画面について質問する」ボタンを押さなくても、Gemini が自発的に画面をキャプチャし、その内容をもとに回答を生成しようと試みます。

プライバシー設定と現時点での精度

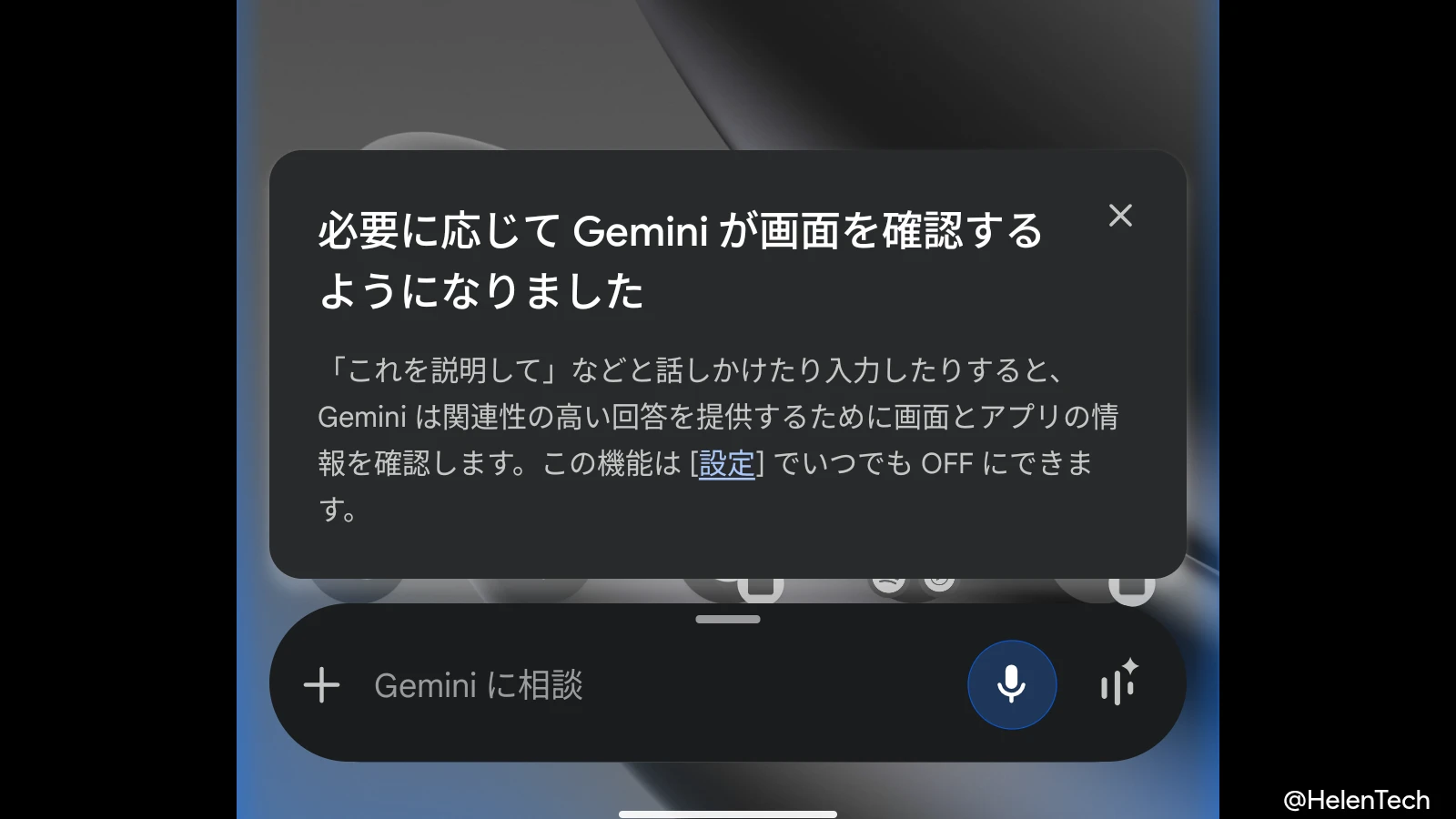

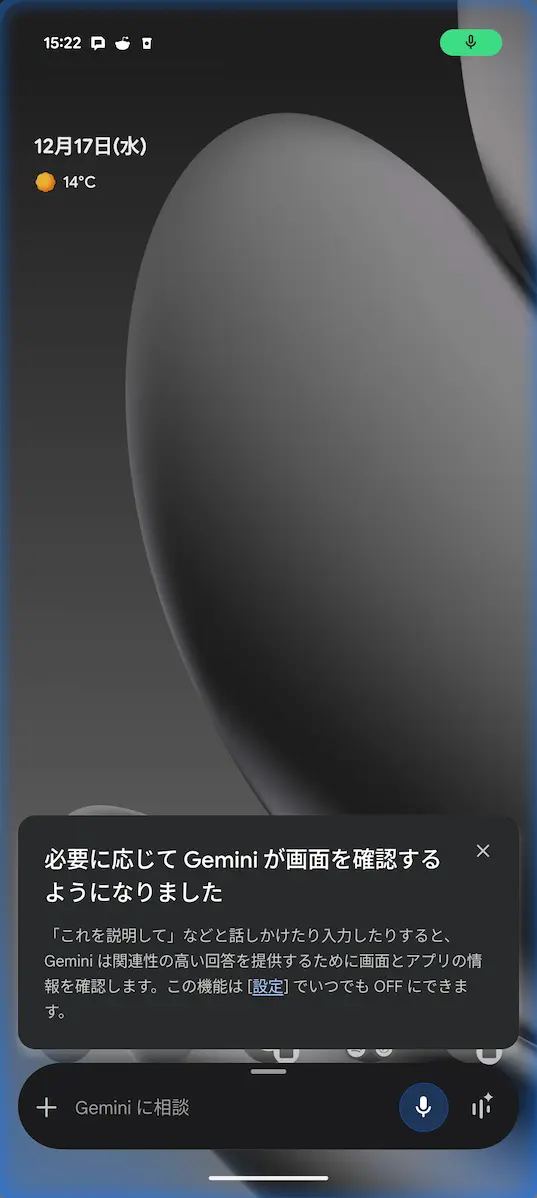

この機能が利用可能になると、Gemini オーバーレイを起動すると「必要に応じて Gemini が画面を確認するようになりました」という通知が表示されます。

通知から、設定でこの自動機能をオフにすることもできるため、画面を勝手に確認されることに対してプライバシーの懸念を抱くユーザーは、オフにしておきましょう。

- Gemini アプリの [Gemini の設定] > [画面のコンテキスト] > [画面のテキストを使用] のトグルをオフ

現在、この機能は一部のユーザーに向けて展開が開始されています。実際に触ってみると、画面上のコンテンツについて聞いていることを Gemini が認識できないことも稀にあり、まだ動作は完璧ではなさそうです。

まとめ

Gemini の新しい「画面のコンテキスト」は、従来の「画面について質問する」をタップする必要なく、画面上の情報を認識できるようになります。

現時点ではすべてのユーザーに展開されているわけではなく、認識精度に課題もありますが、広く展開されるまでには改善していることに期待です。