Android 版 Google アプリの最新ベータ版(v17.2)から、Gemini アプリおよび Gemini Live に今後追加される可能性のある「Labs(ラボ)」機能に関する記述が見つかりました。

この情報は Android Authority が APK 解析によって発見したもので、将来的にユーザーがオプトイン形式で試せる実験的な機能として提供される可能性があります。

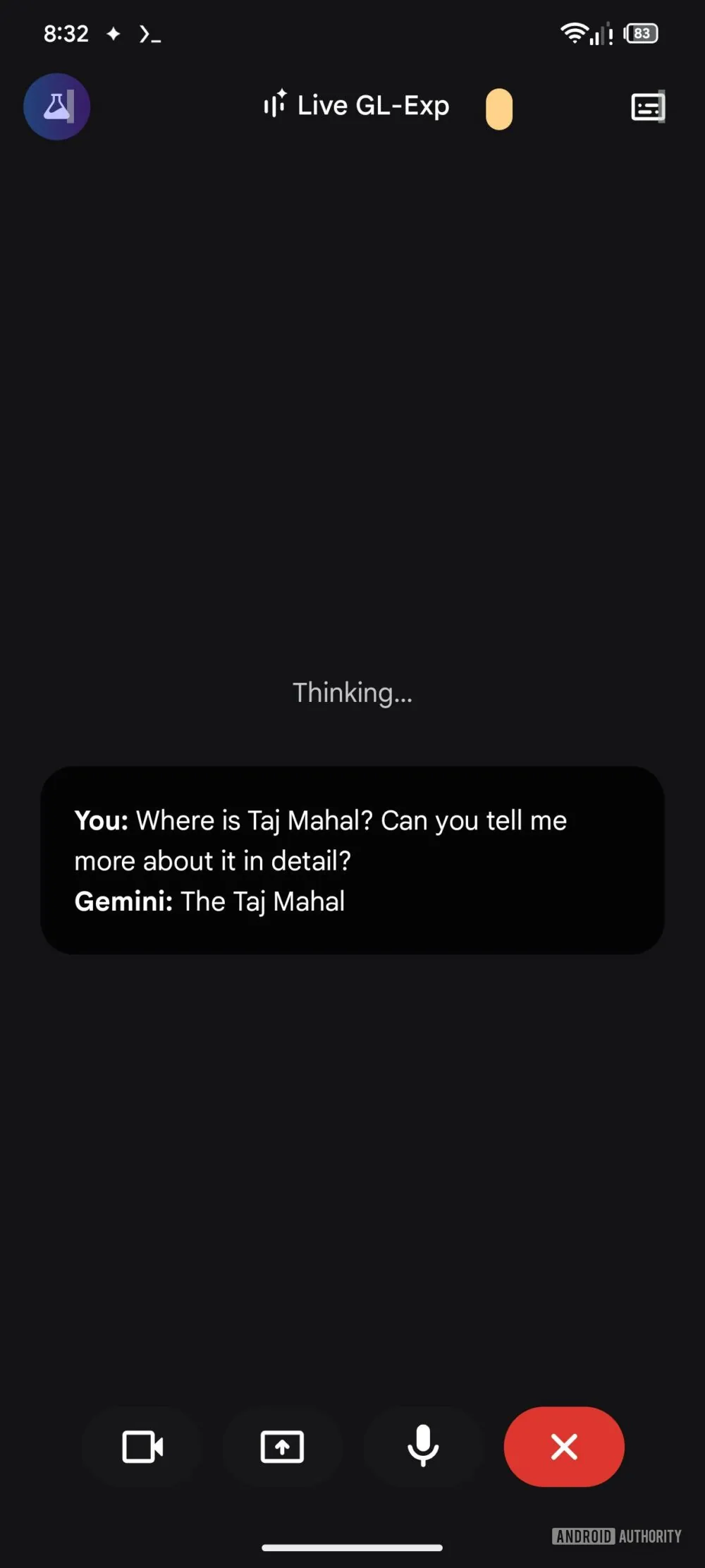

Gemini Live に「思考モード」と実験的機能

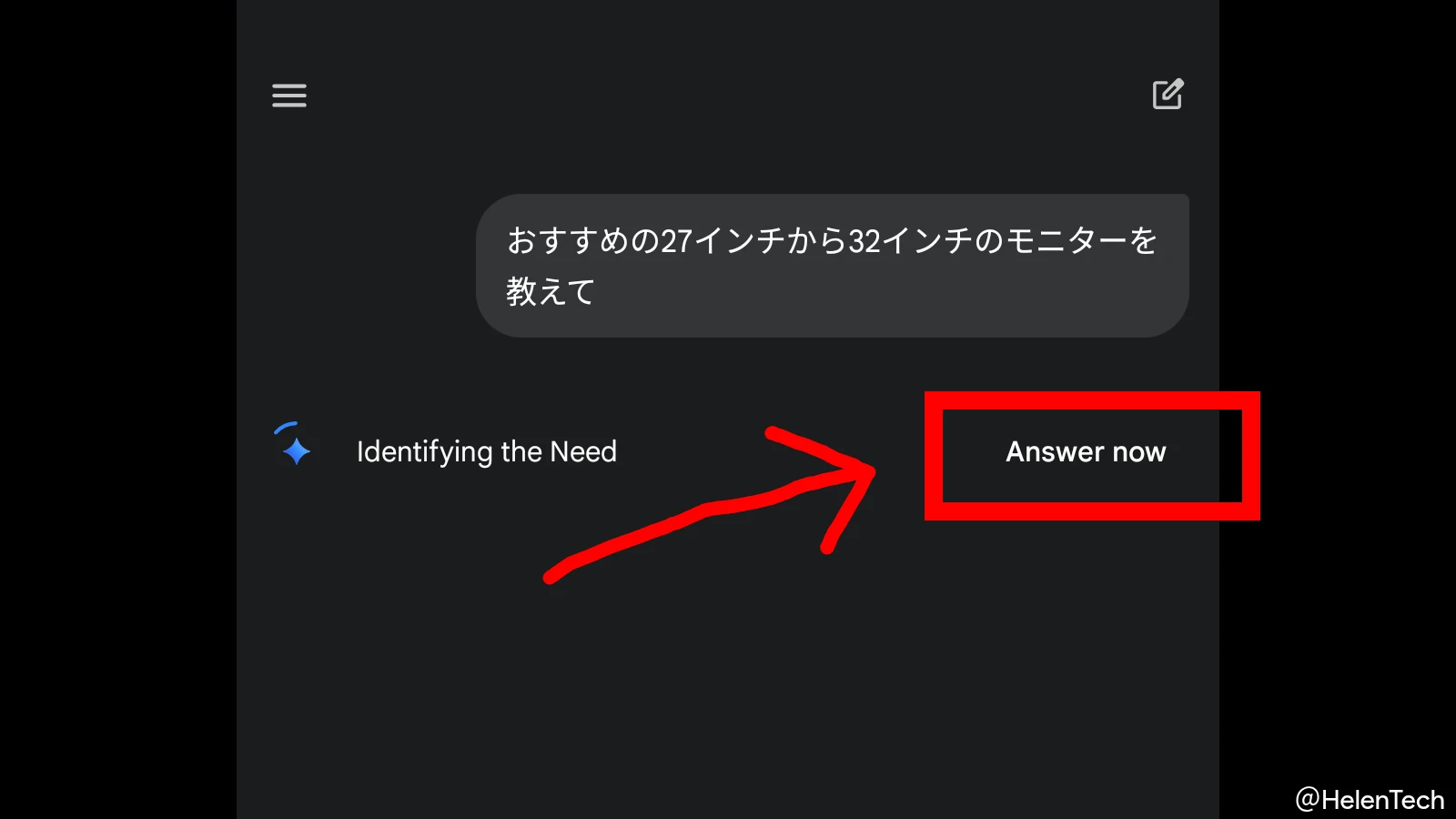

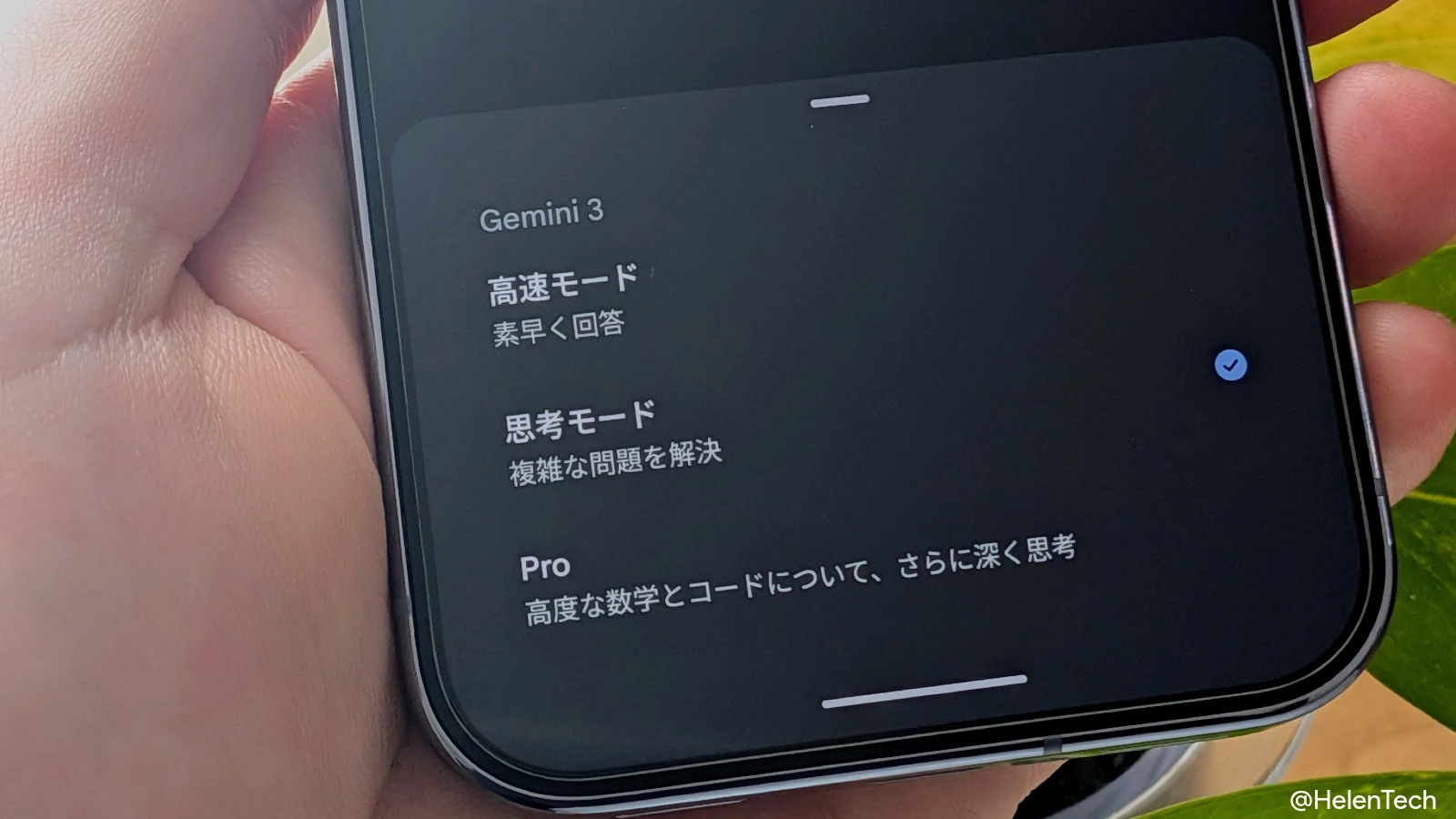

現在、Gemini Live は主に軽量で高速なモデル「Gemini 2.5 Flash」をベースに動作していますが、今回の解析では、より高度な処理を示唆する 2 つの機能が見つかりました。

一つ目は「Live Thinking Mode(ライブ思考モード)」です。 解析された説明文には、「時間をかけて考え、より詳細な回答を提供する Gemini Live のバージョンを試す」といった記述があります。

これは、現在テキスト版の Gemini で利用可能な「思考モード」や、より高性能な「Gemini 3 Pro」モデルを音声会話でも利用可能にするものと推測されます。

二つ目は「Live Experimental Features(ライブ実験機能)」です。 これには、以下の 4 つの機能が含まれるようです。

- マルチモーダルメモリ:会話の内容だけでなく、画像や映像などの情報も記憶する可能性

- ノイズ処理の向上:騒がしい環境でも声を認識しやすくなる

- 視覚への反応(Responding when it sees something):カメラで捉えたものに対してリアルタイムで反応する

- Google アプリに基づくパーソナライズ:ユーザーの使用アプリに基づいた結果の最適化

特に「視覚への反応」は、Google が以前「Project Astra」としてデモを公開していた、スマホのカメラをかざしながらAIと会話する機能を示している可能性があります。

音声会話において「思考モード」が実装されれば、複雑な相談やアイデア出しの壁打ち相手として使う場合、人間と同じように一呼吸置いてから深い洞察を返す、といった挙動になるかもしれません。

「UI Control」でスマホ操作の自動化も示唆

音声機能の強化に加え、エージェント機能(自律的にタスクをこなす機能)に関連する項目も見つかっています。

- UI Control:「エージェントが電話を制御してタスクを完了する」

- Deep Research:「複雑な調査タスクを委任する」

「UI Control」は、ユーザーの代わりに AI がアプリのボタンをタップしたり、画面をスクロールして操作を行ったりする機能を指していると考えられます。

これまでの「Google アシスタント」でも一部のアプリ操作は可能でしたが、Gemini ベースになることで、より汎用的で複雑な操作が可能になると期待されます。

まとめ

今回の情報はあくまでアプリの APK 解析に基づくものであり、すべての機能がそのままリリースされるとは限りません。

しかし、Google が Gemini Live での新機能の開発だけでなく、デバイス操作も AI による自動化に向けて取り組んでいることは間違いなさそうです。

実際にいつリリースされるかは分からず、日本でもリリース後すぐに利用可能になるとも限りませんが、今後の進展に期待です。