Google は 2025 年 9 月 24 日 (現地時間)、大規模言語モデル (LLM) をユーザーのデバイス上で直接実行するための新しい推論フレームワーク「LiteRT-LM」を発表しました。

この技術は、すでに Chrome、Chromebook Plus、Pixel Watch といった Google 製品で Gemini Nano などを動かすために利用されており、その実績あるエンジンが開発者向けに公開されることになります。

これまでも高レベル API を通じてオンデバイス LLM を利用することは可能でしたが、今回初めて、より低レベルな C++ インターフェース (プレビュー版) が提供されます。

これにより、開発者は自身のアプリケーションに最適化された、高性能なカスタム AI パイプラインを構築できるようになります。

オンデバイス生成 AI フレームワーク「LiteRT-LM」とは

「LiteRT-LM」は、Gemini Nano や Gemma といった大規模言語モデル (LLM) を、スマートフォンやパソコン、スマートウォッチなどのエッジデバイス上で、高速かつ効率的に実行するために設計されたフレームワークです。

デバイス上で直接 LLM を実行することには、いくつかの大きなメリットがあります。

- オフライン利用: インターネット接続がない状況でも利用可能

- コスト効率: API 呼び出しごとのコストがかからず、テキストの要約や校正など、頻繁なタスクに適している

- プライバシー: データをデバイス外に送信する必要がないため、プライバシーが保護される

「LiteRT-LM」は、これらのメリットを幅広いデバイスで実現するための技術的課題を解決し、Google の AI Edge スタックの中核を担います。Google AI Edge スタックは以下の階層構造になっています。

- LiteRT: 個々の AI モデルをデバイス上で効率的に実行するための基盤ランタイム

- LiteRT-LM: 複数のモデルや処理を組み合わせ、複雑な生成 AI タスクを実行する C++ ベースの LLM パイプラインフレームワーク

- LLM Inference API: 「LiteRT-LM」を基盤とする、Kotlin、Swift、JS などの高レベル API

今回、このスタックの中間に位置する「LiteRT-LM」の C++ インターフェースが公開されたことで、開発者はプロジェクトのニーズに合わせて、より柔軟で高性能な AI アプリケーションを構築できるようになります。

Chrome や Pixel Watch での導入事例

「LiteRT-LM」は、すでに様々な Google 製品でその実力を発揮しています。Google は性能の異なるデバイスでどのように活用されているか、2 つの事例を紹介しました。

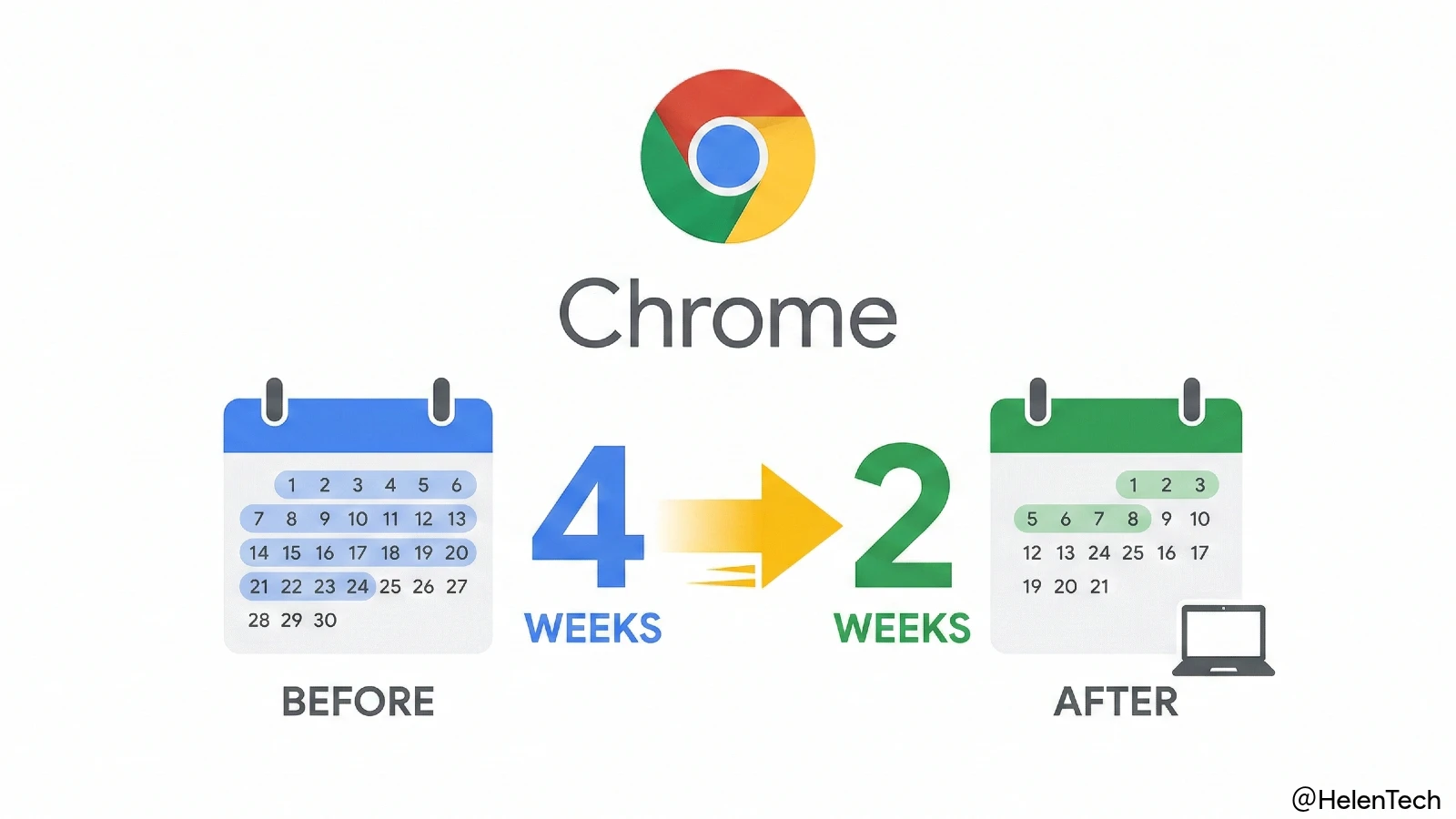

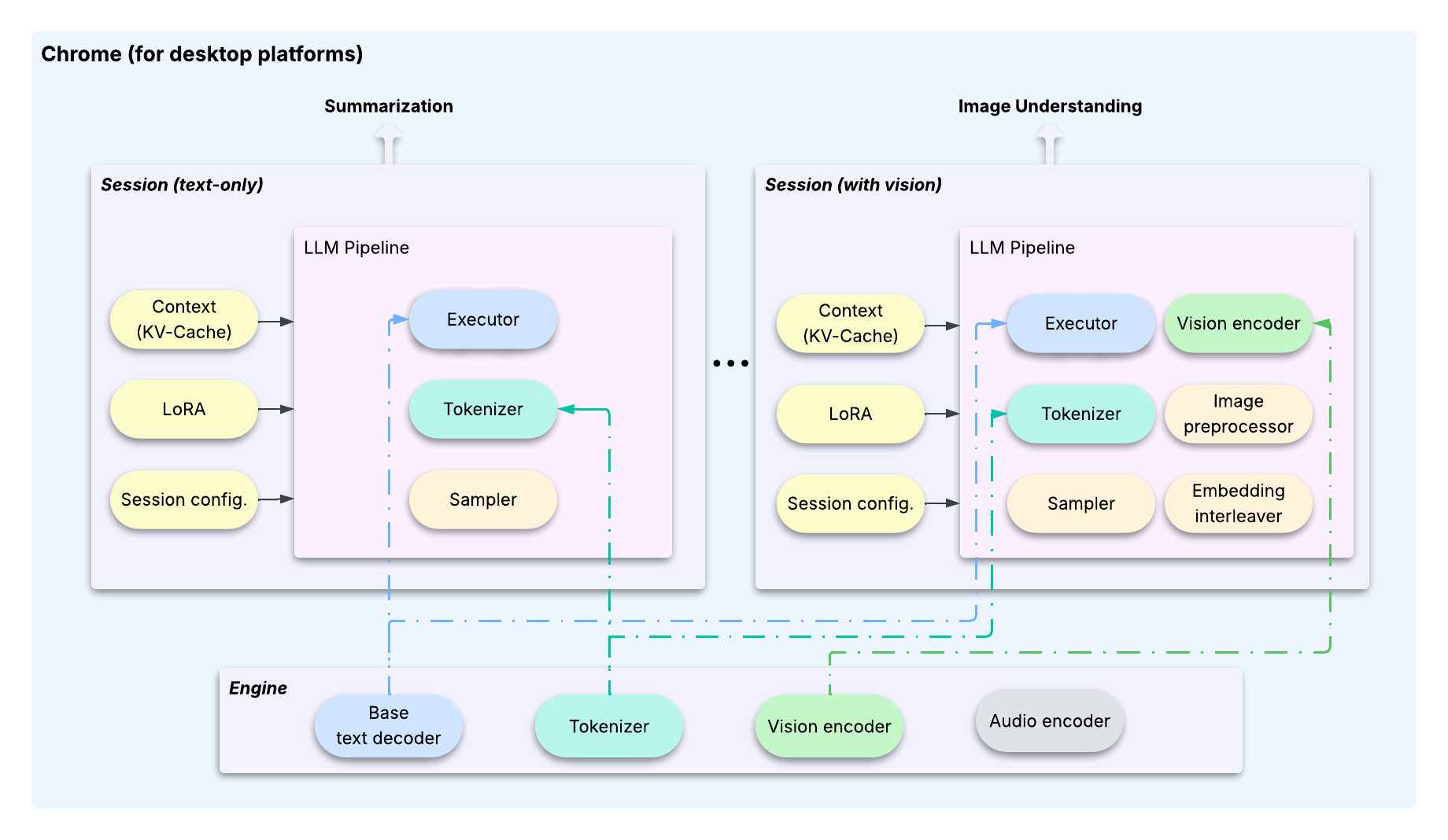

Chrome と Chromebook Plus での活用

Chrome や Chromebook Plus のような比較的高性能なデバイスでは、複数の AI 機能を効率的に動かすことが求められます。通常、機能ごとに専用の大規模モデルを搭載すると、デバイスの容量を大幅に圧迫してしまいます。

「LiteRT-LM」は、この課題を解決するために、1 つの基盤モデルを複数の機能で共有するアーキテクチャを採用しています。軽量なカスタマイズ技術 (LoRA) を用いることで、要約やチャットといった異なるタスクに合わせて、基盤モデルの動作を柔軟に調整します。

また、タスクの切り替えを高速化したり、メモリ使用量を最小限に抑えたりする最適化技術により、ユーザーは複数の AI 機能をスムーズに利用できます。

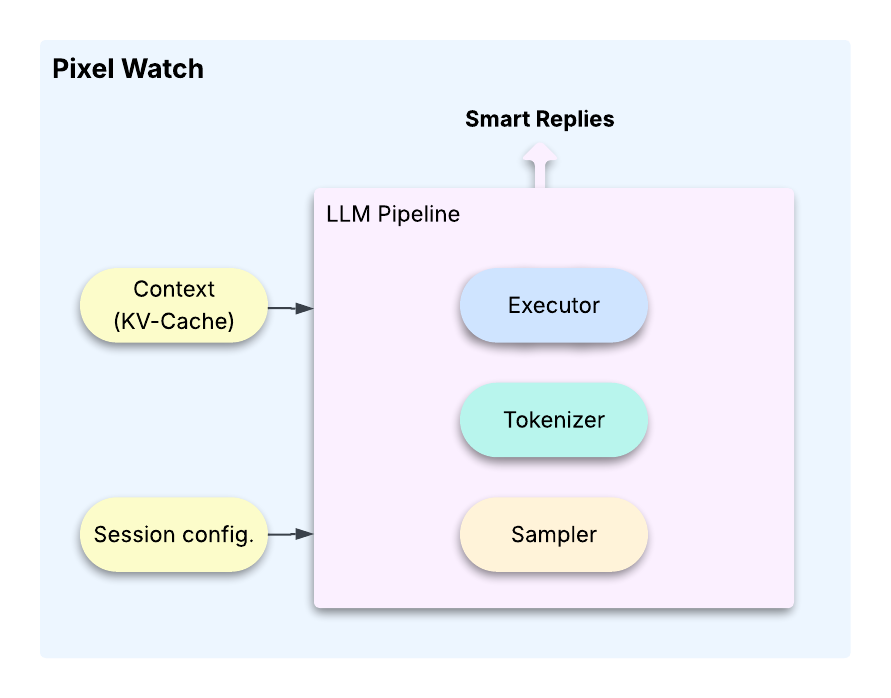

Pixel Watch での活用

一方で、Pixel Watch のようなリソースが極端に限られたウェアラブルデバイスでは、可能な限り小さなプログラムサイズとメモリ使用量で、特定の AI 機能を実装する必要があります。

「LiteRT-LM」のモジュラー設計 (部品のように組み合わせられる設計) は、このような場面で真価を発揮します。

Pixel Watch のスマートリプライ機能では、開発者が必要最小限のモジュール (文章を解釈する部分や応答を生成する部分など) だけを組み合わせて、デバイスの厳しい制約を満たす超軽量な AI パイプラインを構築しました。

このように「LiteRT-LM」は、パワフルなパソコンから小型のウェアラブルデバイスまで、ターゲットとなるデバイスの性能や要件に合わせて、最適な LLM 実行環境を柔軟に構築できるのが大きな強みです。

まとめ

今回 Google が発表した「LiteRT-LM」は、すでに Chrome や Pixel Watch などの製品で広く導入されている、実績のあるオンデバイス生成 AI フレームワークです。

その中核技術がオープンソースとして開発者に提供されることで、今後、さらに多くのアプリケーションで高速かつ効率的なオンデバイス AI 機能が実現されることが期待されます。

ユーザーにとっては、インターネット接続に依存しない、よりレスポンスが速く、プライバシーにも配慮された便利な AI 機能が、様々なデバイスで利用可能になるかもしれません。

より詳しい内容については、Google 公式ブログや GitHub リポジトリなどをご覧ください。

出典: Google